Reinforcement Learning

Reinforcement Learning ist eine wichtige Methode beim Formen einer künstlichen Intelligenz. Wie dieser Ansatz funktioniert und welche Chancen und Herausforderungen er mit sich bringt, erfährst du hier und im Video !

Inhaltsübersicht

Was ist Reinforcement Learning?

Reinforcement Learning (RL), auf Deutsch „verstärkendes“ oder „bestärkendes Lernen“, ist eine Methode des maschinellen Lernens. Ziel von RL ist die Entwicklung einer künstlichen Intelligenz (KI), die selbstständig Aufgaben oder Probleme löst.

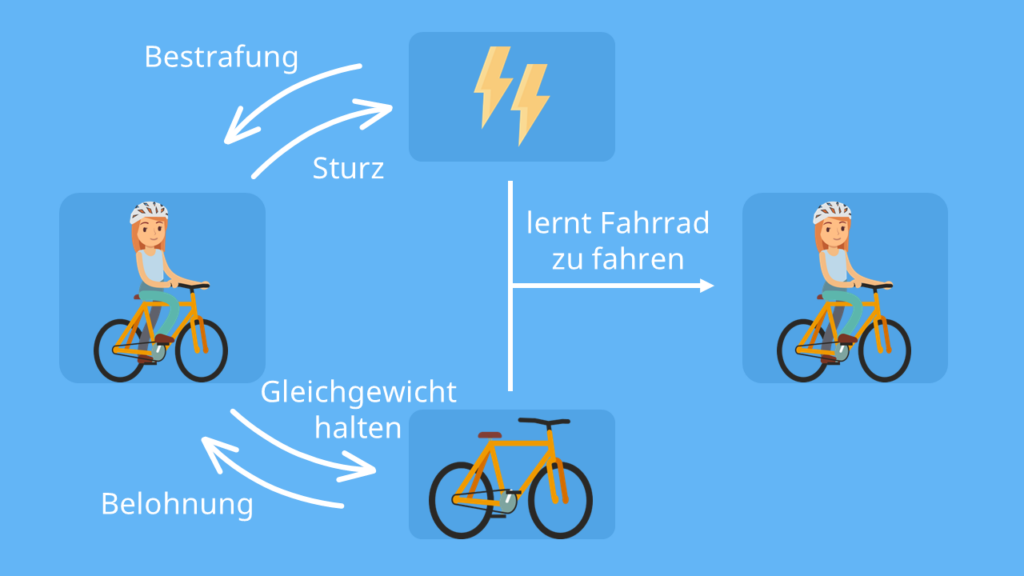

Dabei orientiert sich die Methode am Prinzip von „Belohnung und Bestrafung“ — ähnlich wie wir Menschen oder Tiere durch Erfahrung lernen. Ein Kind lernt beispielsweise Fahrrad zu fahren, indem es ausprobiert, welche Körperbewegungen das Gleichgewicht halten und welche nicht. Die Belohnung ist der Spaß beim Fahren; die Bestrafung ist der Schmerz beim Sturz.

Genau so funktioniert auch Reinforcement Learning: Ein sogenannter „Agent“ (z. B. ein Roboter oder ein Computer) interagiert mit seiner Umgebung, indem er verschiedene Handlungen ausprobiert. Jedes Mal, wenn der Agent eine richtige Entscheidung trifft, bekommt er eine Belohnung; macht er etwas falsch, bekommt er keine. Mit diesen Erfahrungen lernt der Agent, welche Aktionen gut sind und welche nicht.

Reinforcement Learning wird in vielen Bereichen bereits angewendet: Von der Entwicklung autonomer Fahrzeuge über die Optimierung von Ampelschaltungen bis hin zur Erstellung von Chatbots wie ChatGPT. In der Spieleentwicklung hat RL beispielsweise dazu geführt, dass künstliche Intelligenzen komplexe Spiele wie Go auf einem Niveau meistern, das menschliche Profispieler übertrifft.

Wie funktioniert Reinforcement Learning?

Das grundlegende mathematische Konzept hinter Reinforcement Learning ist der Markov-Entscheidungsprozess (MDP).

Dieser beschreibt, dass jede Entscheidung der Maschine beeinflusst, was als nächstes passiert. Eine zukünftige Situation ist dabei nur von der aktuellen Situation und der gewählten Entscheidung abhängig — nicht von der gesamten vorherigen Geschichte.

Das ist eine Vereinfachung, die der Maschine das Lernen erleichtert. Ziel ist es, eine Strategie zu finden, die langfristig die maximale Belohnung bringt. Und genauso funktioniert es auch beim bestärkenden Lernen.

Studyflix vernetzt: Hier ein Video aus einem anderen Bereich

Wichtige Begriffe beim Bestärkenden Lernen

Doch bevor wir uns den Ablauf von RL genauer anschauen, gibt es ein paar wichtige Grundbegriffe zu erklären:

-

Agent: Der Agent ist derjenige, der die Entscheidungen trifft — also ein Computeralgorithmus.

→ Beispiel: Im Fall eines selbstfahrenden Autos ist der Agent das System, das das Auto steuert.

-

Umgebung (environment): Die Umgebung ist die Welt, in der sich der Agent bewegt. Sie ändert sich durch jede Aktion des Agenten, aber kann sich auch von selbst ändern. Außerdem enthält die Umgebung alle Entscheidungen, die der Agent treffen könnte.

→ Beispiel: Beim selbstfahrenden Auto wäre die Umgebung ein simulierter Stadtverkehr mit Verkehrsschildern, anderen Autos, Fußgängern, Wetterbedingungen, etc.

-

Zustand (state): Der Zustand beschreibt die aktuelle Situation des Agenten in der Umgebung. Er enthält alle relevanten Informationen, die der Agent benötigt, um eine Entscheidung zu treffen.

→ Beispiel: Für das Auto könnten zum Zustand die aktuelle Position, die Anzahl der anderen Autos und die eigene Geschwindigkeit gehören.

-

Aktion: Das ist die Entscheidung, die der Agent in einem bestimmten Moment trifft.

→ Beispiel: Das Auto bremst, weil die Ampel rot ist.

-

Belohnung (reward): Nach jeder Aktion erhält der Agent eine Rückmeldung in Form einer Belohnung oder Strafe. Der Agent versucht dabei, die Summe der Belohnungen über die Zeit zu maximieren.

→ Beispiel: Das Auto erhält eine Bestrafung, wenn es eine rote Ampel überfährt.

Übrigens: Die Belohnung wird von Entwicklern einer KI mit einer mathematischen Belohnungsfunktion programmiert. Das können z. B. ganz einfach +10 Punkte bei einer guten Aktion oder -10 Punkte bei einer schlechten Aktion des Agenten sein.

-

Strategie (policy): Der Agent entwickelt mit jedem Versuch eine Strategie, die für jeden Zustand angibt, welche Aktion auszuführen ist. Ziel beim RL ist es, die Richtlinie so zu optimieren, dass sie zu maximaler Belohnung führt.

→ Beispiel: Um im Straßenverkehr sicher zu navigieren, lernt das Auto, dass es z. B. bei einer roten Ampel stoppen und bei Platzregen langsamer fahren soll.

Grundlegender Ablauf

Der RL-Prozess beginnt damit, dass der Agent in einem bestimmten Zustand seiner Umgebung eine Aktion wählt. Zum Beispiel fährt das selbstfahrende Auto auf einer leeren Straße und entscheidet sich zu beschleunigen.

Diese Aktion hat nun Auswirkungen auf die Umgebung, wodurch sich der Zustand ändert. Das Auto bewegt sich weiter vorwärts und es erreicht voraussichtlich sein Ziel schneller — eine Belohnung. Das signalisiert ihm, dass seine Entscheidung gut war.

Nun kommt es auf einen Straßenabschnitt mit einer Geschwindigkeitsbegrenzung von 30, doch es fährt weiterhin 80 km/h. Unser Auto hat nämlich noch nicht gelernt, dass manche Straßenschilder eine Geschwindigkeitsbegrenzung signalisieren und es gerät in einen Blitzer — eine Bestrafung. In Zukunft wird der Agent daher diese Aktion vermeiden, um nicht wieder eine Bestrafung zu erhalten.

Der Agent wiederholt diesen Zyklus immer wieder: Zustand → Aktion → neuer Zustand → Belohnung. Mit der Zeit erstellt er eine Reihe von Wenn-Dann-Regeln (Policies), die ihm zeigen, welche Aktionen ihn näher an sein Ziel bringen, welche ihn davon abhalten und wie er die maximale Belohnung erhält.

Lernen durch „Versuch und Irrtum“

Unser Beispiel verdeutlicht außerdem einen zentralen Aspekt des verstärkenden Lernens: Trial & Error (dt.: Versuch & Irrtum). Der Agent muss durch mehrere Versuche herausfinden, welche Aktionen gut sind und welche nicht. Anfangs wählt er oft zufällige Aktionen und macht viele Fehler, um die Umgebung besser kennenzulernen.

Der Agent kann außerdem lernen, dass es manchmal klug ist, kurzfristig auf Belohnungen zu verzichten, wenn er dafür langfristig einen größeren Erfolg erzielen kann. Schließlich möchte niemand in ein Auto steigen, das bei jeder grünen Ampel Vollgas gibt. Das ist nicht nur gefährlich, sondern auch ziemlich anstrengend für die Insassen. Mit der Zeit wird der Agent aber immer geschickter darin, kluge Entscheidungen zu treffen.

Hat der Agent einmal sein Ziel erreicht, ist er dazu geneigt, diesen Weg immer wieder einzuschlagen, d. h. ihn auszunutzen (engl.: exploit). Doch womöglich findet er noch einen kürzeren Weg. Um den zu finden, müsste er die Umgebung weiter erkunden (engl.: explore).

Dieser Balanceakt zwischen Ausnutzen (ganz sicher zum Ziel gelangen) und Erkunden (potenziell besseren Weg finden) ist entscheidend für den langfristigen Erfolg des Agenten.

Schon gewusst? Bis ein Programm komplett einsatzbereit ist, braucht es eine sehr große Anzahl von Interaktionen zwischen dem Agenten und der Umgebung. Das Computerprogramm AlphaGo, wurde z. B. über mehrere Tage ununterbrochen trainiert, indem es Millionen von Spiele spielte und sich dabei Jahre an menschlichem Wissen aneignete.

Arten des Reinforcement Learning

Für das Reinforcement Learning können verschiedene Algorithmen eingesetzt werden, die die Aktionen des Agenten steuern. Dazu gehören Q-Learning, Policy-Gradient-Methoden, Monte-Carlo-Methoden und Temporal Difference Learning.

Sie unterscheiden sich zwar in ihrer Herangehensweise, verfolgen aber alle dasselbe Ziel: den Agenten zu befähigen, in einer Umgebung die optimale Strategie zu erlernen, um Belohnungen zu maximieren. Insgesamt lassen sich alle Algorithmen in zwei Gruppen unterteilen: modellbasiertes und modellfreies RL.

Modellbasiertes Reinforcement Learning

Bei modellbasierten Reinforcement Learning, erstellt der Agent ein Modell der Umgebung, um daran seine Aktionen zu planen.

Angenommen, du möchtest einem Roboter beibringen, einen Raum zu putzen. Dafür würde der Roboter frei durch die Wohnung fahren und eine Karte davon erstellen, die alle Möbel, Türen und andere Objekte beinhaltet. Zudem probiert er für jede Stelle eine Reinigungsmethode und notiert sich, ob sie eine Belohnung bringt.

Mit diesem Plan kann er dann verschiedene Reinigungsrouten simulieren und abschätzen, welche am effizientesten ist, ohne dass er jede Aktion erst ausprobieren muss.

Diese Form von RL wird verwendet, wenn die Umgebung einfach zu modellieren ist und sich kaum verändert. Das betrifft z. B. industrielle Bereiche, wo modellbasiertes RL in der Lagerhaltung oder für effizientere Lieferketten angewendet wird.

Modellfreies Reinforcement Learning

Beim modellfreien RL lernt der Agent hingegen durch direkte Erfahrung. Unser Roboter würde hier also direkt eine Reinigungsroute ausprobieren und sehen, wie viele positive oder negative Rückmeldungen er erhält.

Erst über viele Versuche hinweg lernt der Roboter, welche Aktionen (z. B. saugen, wischen) in welchen Situationen (z. B. auf Teppich, auf Fliesen) zu den besten Ergebnissen führen.

Dieses Modell ist besser für komplexe und sich ändernde Umgebungen geeignet. Denn es sorgt dafür, dass der Agent flexibel agiert und nicht strickt einem Modell folgt. Ein modellbasierter Ansatz könnte hier nämlich dafür sorgen, dass unser Roboter womöglich über die Hauskatze fährt, nur weil er in kürzester Zeit die Wohnung geputzt haben möchte.

Gut zu wissen: Für besonders komplexe und hochdimensionale Aufgaben wird das Deep Reinforcement Learning (DRL) verwendet: eine Mischung aus klassischem RL und künstlichen neuronalen Netzen. Das kann nämlich mit viel mehr Faktoren umgehen — seien es die Millionen Pixel in einem Videospiel oder die zahlreichen Einflussfaktoren beim Autofahren.

Reinforcement Learning — Anwendung

Durch Reinforcement Learning kann eine KI komplexe Probleme durch kontinuierliches Lernen lösen. Das hat bereits in vielen Branchen Anwendungen gefunden. Hier ein paar Beispiele:

-

⚖️ Dynamic Pricing: In der Preisgestaltung wird Reinforcement Learning verwendet, um Preise in Echtzeit an Angebot und Nachfrage anzupassen. Durch die Analyse von Kundenverhalten und Marktbedingungen erhöht oder senkt der Agent die Preise, um den Umsatz zu maximieren und die Kundenbindung zu fördern.

-

⚡️ Energieeffizienz: Reinforcement Learning kann dabei helfen, die Energieeffizienz zu verbessern. Ein Beispiel dafür ist Google, die RL verwenden, um die Klimaanlagen in ihren Rechenzentren zu steuern. Die benötigen nämlich enorme Mengen an Energie, um die Server vor Überhitzung zu schützen. Doch mit RL konnten sie ihren Energieverbrauch um 40 % reduzieren.

- ⚙️ Natürliche Sprachverarbeitung (NLP): Reinforcement Learning kann verwendet werden, um Chatbots und Sprachassistenten so zu trainieren, dass sie natürlichere und sinnvollere Antworten liefern. Der Agent erhält Feedback, wie zufrieden der Nutzer mit der Antwort ist, und passt sich an, um im nächsten Gespräch besser zu reagieren.

Verstärkendes, überwachtes & unüberwachtes Lernen

Maschinelles Lernen kann grob in drei Hauptkategorien unterteilt werden: überwachtes Lernen (Supervised Learning), unüberwachtes Lernen (Unsupervised Learning) und verstärkendes Lernen (Reinforcement Learning). Sie alle haben unterschiedliche Ziele und Funktionsweisen.

Beim überwachten Lernen lernt das System aus beschrifteten Daten. Das bedeutet, dass der Algorithmus Trainingsdaten erhält, bei denen die gewünschten Ergebnisse vorgegeben sind. Ziel des überwachten Lernens ist, aus diesen Beispielen eine allgemeine Regel abzuleiten, um neue und unbekannte Daten korrekt zu kategorisieren.

Auch beim unüberwachten Lernen wird das System mit einem Datensatz gefüttert. Der Unterschied ist, dass es unbeschriftete Daten erhält und versucht, darin Ähnlichkeiten oder Unterschiede zu erkennen, um die Daten zu ordnen oder zu verknüpfen.

Im Gegensatz zu den beiden Methoden lernt der Agent beim verstärkenden Lernen durch Erfahrung und Feedback. Der Hauptunterschied ist, dass das System nicht auf einen festen Datensatz angewiesen ist, sondern die Daten durch Interaktion mit der Umgebung selbst erzeugt.

Vor- und Nachteile vom Reinforcement Learning

Die Methode des Reinforcement Learning bietet viele Vorteile. Der wohl größte Vorteil ist dabei, dass es für komplexe und dynamische Umgebungen geeignet ist, in denen es keine klare Lösung gibt. Denn der Agent lernt für jede mögliche Situation durch wiederholtes Ausprobieren, welche Aktionen am besten sind.

Das macht Reinforcement Learning auch sehr flexibel: Da der Agent kontinuierlich lernt und sich an Veränderungen in der Umgebung anpasst, kann er auf eine Vielzahl von Problemen vorbereitet sein.

Ebenfalls vorteilhaft ist, dass Reinforcement Learning wenig menschlichen Eingriff erfordert. Sobald die Belohnungsstruktur und die Umgebung definiert sind, lernt der Agent selbstständig aus seinen Handlungen und dem erhaltenen Feedback.

Herausforderungen beim Bestärkenden Lernen

Trotz dieser Vorteile gibt es auch Herausforderungen. Eine wesentliche Schwierigkeit beim Reinforcement Learning ist, dass es bei sicherheitskritischen Anwendungen problematisch sein kann. Denn RL hat mit dem Exploration-Exploitation-Dilemma zu kämpfen: Entweder der Agent erkundet neue Zustände (Exploration) oder nutzt bekanntes Wissens (Exploitation).

In Bereichen wie der Medizin, wo Exploration Menschenleben gefährden könnte, ist es riskant, RL einzusetzen. Denn hier ist die Fehlertoleranz sehr gering.

Eine weitere Herausforderung ist die Anwendbarkeit in der realen Welt. Das Experimentieren mit realen Belohnungssystemen ist oft schwierig oder sogar gefährlich — daher werden die Umgebungen simuliert.

Doch das Training in einer Simulation ist nicht immer vergleichbar mit der realen Welt. In der Praxis bedeutet das, dass der Algorithmus möglicherweise nicht schnell genug oder nicht angemessen reagieren kann.

Für Entwickler ist aber vor allem die Formulierung der Belohnungsfunktion — auch Reward Shaping genannt — eine große Herausforderung. Wenn die Belohnungen schlecht definiert oder zu einfach gestaltet sind, kann der Agent trotz Belohnung ungünstige Strategien entwickeln. Doch es ist oft nicht leicht, alle relevanten Aspekte einer Aufgabe in einer einzigen Funktion zu erfassen.

RLHF

Das Problem des Reward Shaping kann mit einer Weiterentwicklung des Reinforcement Learning angegriffen werden: dem Reinforcement Learning from Human Feedback (RLHF). Hier wird die Belohnungsfunktion durch menschliches Feedback ergänzt. Damit können z. B. schädliche, falsche oder voreingenommene Ergebnisse verhindert werden. Mehr zum Thema „RLHF“ findest du in unserem Video dazu!

Reinforcement Learning — häufigste Fragen

(ausklappen)

Reinforcement Learning — häufigste Fragen

(ausklappen)-

Was ist Reinforcement Learning?Reinforcement Learning ist eine Methode des maschinellen Lernens, bei der ein System durch Interaktion mit seiner Umgebung lernt. Es erhält Belohnungen oder Bestrafungen für seine Handlungen und entwickelt schrittweise Strategien, um langfristig die maximale Belohnung zu erreichen.

-

Wie funktioniert Reinforcement Learning?Beim Reinforcement Learning wählt der Agent in einem bestimmten Zustand eine Aktion, um ein Ziel zu erreichen. Die Aktion verändert seine Umgebung und er erhält, je nach Ausgang seiner Handlung, eine Belohnung oder Bestrafung. Durch wiederholtes Ausprobieren und Feedback verbessert der Agent seine Strategie.

-

Was ist ein Agent in Reinforcement Learning?Ein Agent ist das lernende System im Reinforcement Learning, das mit seiner Umgebung interagiert. Das könnte z. B. ein selbstfahrendes Auto, ein Roboter oder ein Computer sein.